ICLR神秘论文曝光!SAM3用「概念」看世界,重构视觉AI新范式

ICLR神秘论文曝光!SAM3用「概念」看世界,重构视觉AI新范式2023年Meta推出SAM,随后SAM 2扩展到视频分割,性能再度突破。近日,SAM 3悄悄现身ICLR 2026盲审论文,带来全新范式——「基于概念的分割」(Segment Anything with Concepts),这预示着视觉AI正从「看见」迈向真正的「理解」。

2023年Meta推出SAM,随后SAM 2扩展到视频分割,性能再度突破。近日,SAM 3悄悄现身ICLR 2026盲审论文,带来全新范式——「基于概念的分割」(Segment Anything with Concepts),这预示着视觉AI正从「看见」迈向真正的「理解」。

一年一度ICLR 2025杰出论文开奖!普林斯顿、UBC、中科大NUS等团队的论文拔得头筹,还有Meta团队「分割一切」SAM 2摘得荣誉提名。

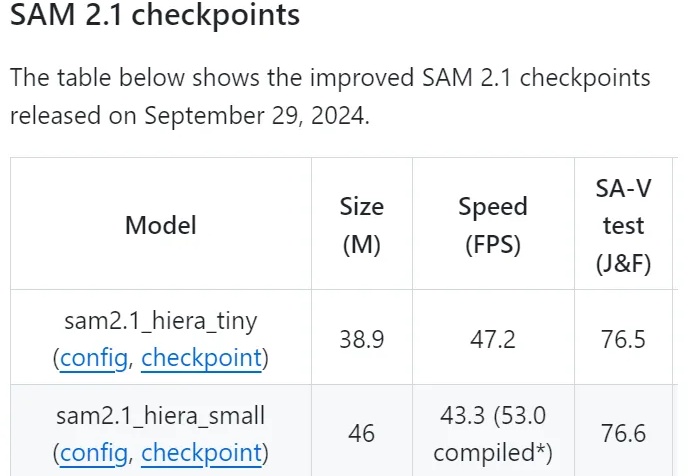

Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

Meta的视频版分割一切——Segment Anything Model 2(SAM 2),又火了一把。

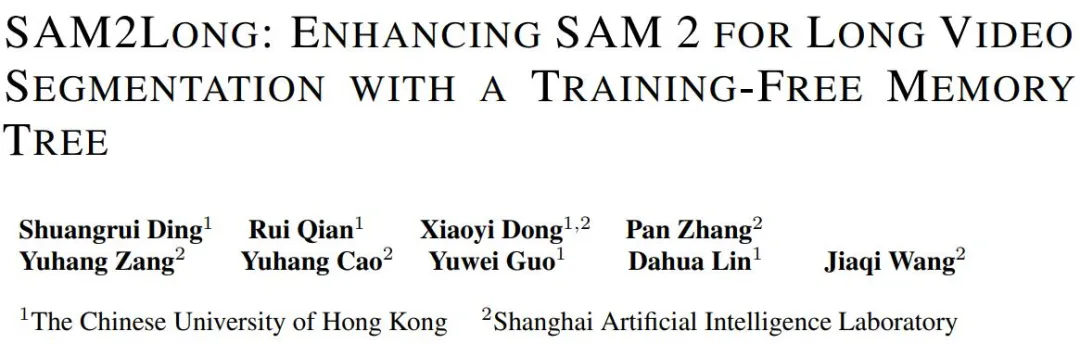

Segment Anything Model 2(SAM 2)在传统视频目标分割任务大放异彩,引起了众多关注。然而,港中文和上海 AI Lab 的研究团队发现 SAM 2 的贪婪选择策略容易陷入「错误累积」的问题,即一次错误的分割掩码选择将影响后续帧的分割结果,导致整个视频分割性能的下降。这个问题在长视频分割任务中显得更加严重。

今天,Meta 分享了一系列研究和模型,这些研究和模型支撑 Meta 实现高级机器智能(AMI)目标,同时也致力于开放科学和可复现性。

免训练多模态分割领域有了新突破!

Meta又双叒开源了!继去年初代SAM掀翻CV圈之后,SAM 2也完成了终极进化,不仅能分割图像,最惊艳的是还能分割视频。这下,CV可能就真的不存在了。

还记得 Meta 的「分割一切模型」吗?这个模型在去年 4 月发布,被很多人认为是颠覆传统 CV 任务的研究。